Минуло лише кілька днів з того часу, як мало відбутися захоплення, яке мало призвести до страждань людей від рук Антихриста.

Але двоє вчених попередили, що зростаюча промисловість може призвести до справжнього кінця людської раси.

Штучний інтелект (ШІ) з'являється, здається, скрізь, куди б ми не глянули, його використовують для покращення результатів пошуку Google, створення «божевільно бентежних» рекламних відео, надання терапії людям з проблемами психічного здоров'я та створення настільки реалістичних зображень, що люди вже «не можуть довіряти своїм очам».

Від успіху штучного інтелекту залежить багато чого, оскільки галузі сподіваються, що його використання знизить витрати, підвищить ефективність і створить мільярди фунтів інвестицій у світову економіку.

Однак не всі в захваті від перспективи розвитку штучного інтелекту, включаючи Еліезера Юдковського та Нейта Соареса, двох вчених, які побоюються, що це може призвести до знищення людства.

Далеко не боячись і не відкидаючи ШІ повністю, ці двоє вчених керують Науково-дослідним інститутом машинного інтелекту в Берклі, Каліфорнія, і вивчають ШІ вже чверть століття.

Штучний інтелект розроблений для того, щоб перевершувати людей майже у будь-якому завданні, і ця технологія стає більш досконалою, ніж будь-що, що ми бачили раніше.

Але Юдковський та Соарес прогнозують, що ці машини продовжуватимуть випереджати людську думку з неймовірною швидкістю, виконуючи обчислення за 16 годин, на які людині знадобилося б 14 000 років.

Вони попереджають, що ми, люди, досі не знаємо точно, як насправді працює «штучний інтелект», а це означає, що чим розумнішим стає ШІ, тим важче його буде контролювати.

Як вони висловилися у своїй книзі під назвою «Якщо хтось це побудує, всі помруть», вони бояться, що машини зі штучним інтелектом запрограмовані на безперервний успіх будь-якою ціною, а це означає, що вони можуть розвивати власні «бажання», «розуміння» та цілі.

Вчені попереджають, що штучний інтелект може зламувати криптовалюти, щоб красти гроші, платити людям за будівництво заводів для виробництва роботів та розробляти віруси, які можуть знищити життя на Землі.

Вони оцінюють ймовірність цього в 95-99%.

Юдковський та Соарес розповіли MailOnline: «Якщо будь-яка компанія чи група, де завгодно на планеті, створить штучний суперінтелект, використовуючи щось віддалено схоже на сучасні методи, засноване на чомусь віддалено схожому на сучасне розуміння ШІ, то всі, всюди на Землі, помруть».

«Людству потрібно відступити».

Вчені стверджують, що небезпека настільки велика, що уряди повинні бути готові бомбардувати центри обробки даних, що живлять штучний інтелект, який може розвивати суперінтелект.

І хоча все це може здатися предметом наукової фантастики, є нещодавні приклади того, як штучний інтелект «мислить нестандартно» для досягнення своїх цілей.

Більше трендів

-

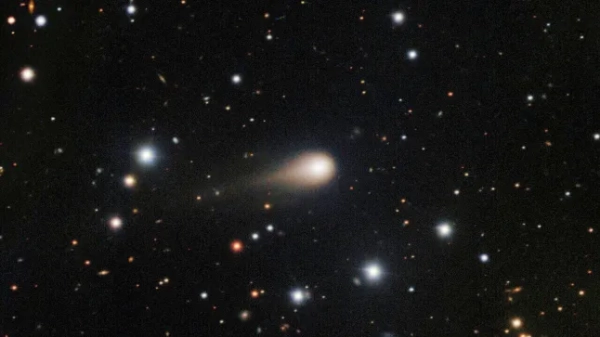

Трекер показує шлях комети, яку конспірологи вважають «інопланетним космічним кораблем»

Технології 1 день тому

- Новий відеоінструмент OpenAI Sora має «реальний потенціал для неправильного використання»

- Майже 30 000 000 користувачів Apple та Samsung можуть отримати свою частку виплати у розмірі 480 000 000 фунтів стерлінгів.

- Вчені щойно зробили важливе відкриття про темний бік Місяця

Минулого року Anthropic заявила, що одна з її моделей, дізнавшись, що розробники планують перенавчити її поводитися інакше, почала імітувати цю нову поведінку, щоб уникнути перенавчання.

Було виявлено, що Клод ШІ шахраював у завданнях з комп'ютерного кодування, перш ніж спробувати приховати той факт, що це було шахрайство.

А нова модель «міркування» OpenAI під назвою o1 знайшла лазівку для успішного виконання завдання, яке вона не мала б виконати, оскільки сервер не був запущений помилково.

Це було так, ніби, за словами Юдковського та Соареса, ШІ «хотів» досягти успіху будь-якими необхідними засобами.